近日,我校计算机与人工智能学院跨媒体计算与数字孪生团队熊明福老师课题组在多媒体信息处理,图像视频分析和人工智能方面取得了系列重要进展,相关成果以武汉纺织大学为第一单位发表在该领域IEEE TMM、IEEE TCSVT和Information Fusion等顶级期刊。

成果1:“Adaptive Clustering and Weighted Regularization Contrastive Learning Framework for Unsupervised Person Re-identification”,被多媒体信息处理领域顶级期刊《IEEE Transactions on Multimedia》(IEEE TMM,中科院一区Top,IF 9.7)接收。该论文由熊明福老师指导的2022级硕士研究生胡凯康完成,第一单位为武汉纺织大学。

文章链接:https://ieeexplore.ieee.org/abstract/document/11086410

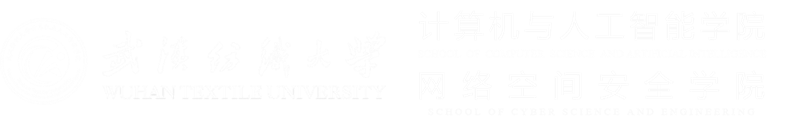

无监督行人重识别旨在无需任何数据标注的情况下,能够有效地识别不通状态下的同一目标对象,在刑事侦查、公共安全领域具有重要的作用。本文针对当前无监督聚类方法主要依赖于固定的阈值(样本点和聚类质心之间的最大距离),忽略了在连续模型优化过程中调整该阈值的重要性,而导致聚类阈值与类内间距不匹配的问题,本文提出了一种自适应聚类和加权正则化对比学习方法,主要包括聚类阈值自适应调整模块和加权正则化对比学习模块,使得模型在训练过程中自适应地调整样本实例与聚类中心的距离,有效解决了聚类阈值与模型训练进程不匹配的问题,并提升了模型收敛的速率。

图1 自适应聚类距离算法框架

实验结果表明,本文方法在当前5个主流公开的数据集上都获得了最优的性能,实现了自适应聚类距离的调整和算法快速收敛的有效统一。

成果2:“HPRNet: Human Parsing Reconstruction with Non-Local Multi-Scale Perception Network for Cloth-Changing Person Re-Identification”,被视频和图像技术分析领域顶级期刊《IEEE Transactions on Circuits and Systems for Video Technology》(IEEE TCSVT,中科院一区Top,IF 11.1)接收。该论文由熊明福老师指导的2023级硕士生葛龙龙完成,论文的第一单位为武汉纺织大学。

文章链接:https://ieeexplore.ieee.org/abstract/document/11121372

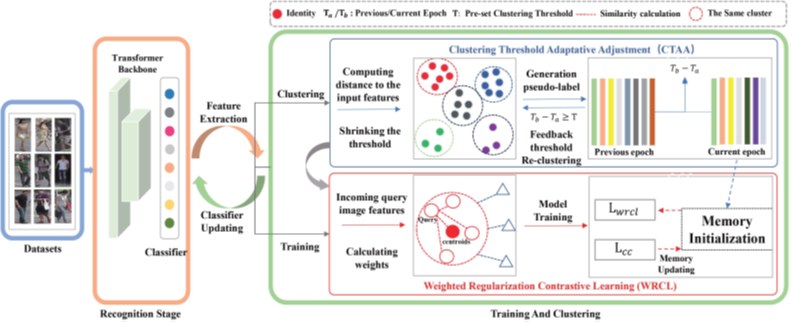

换衣行人重识别旨在匹配不同时间、不同地点、并且依着外貌不同的行人是否同一对象目标的技术,其同样在公共安全、形式破案领域具有重要的作用。本文针对现有的方法主要集中在改变服装颜色和直接重建外观上,而忽略了行人身高、体型等差异而导致识别性能降低的问题。提出了一个名为“非局部多尺度感知网络的行人解析重建”框架,包括非局部加权多尺度感知模块和行人解析重建探索模块。其中非局部加权多尺度感知模块有效地获取了行人样本的全局感受野和样本图像内非相邻像素之间的上下文相关性。行人重建解析模块用于通过服装解析模型更准确地重建人体组件,以更好地区分与服装相关或无关的特征,有效提升了换衣重识别的精度。

![]()

图2 非局部多尺度感知与行人解析框架

实验结果表明,本文方法在换衣行人重识别公共数据集(LTCC、PRCC和CCVID)上进行了广泛的实验,以证明所提出的方法与当前最先进的(SOTA)方法对比,都取得了最优和具有竞争力的性能。

成果3:“RFFR-Net: Robust feature fusion and reconstruction network for clothing-change person re-identification”被人工智能、数据融合、信息安全等领域顶级期刊《Information Fusion》(中科院一区Top,IF 15.5)接收。熊明福老师指导2022级硕士生杨欣馨完成,论文的第一单位为武汉纺织大学。

文章链接:https://www.sciencedirect.com/science/article/abs/pii/S1566253524006638

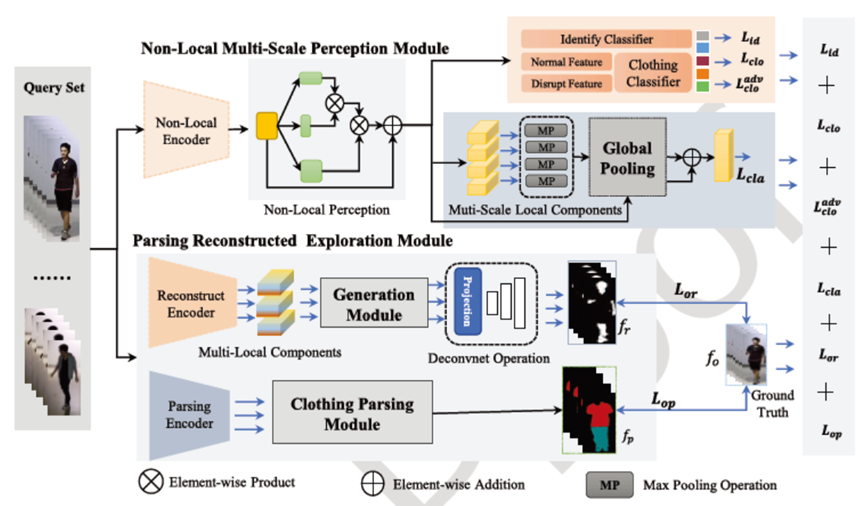

换衣行人重识(Clothing-change Person Re-identification,CC-ReID)别旨在获取与行人衣物无关的特征,以此匹配不同场景下的目标对象。现有方法在对行人外观特征获取时,主要依赖于其固有的不稳定的服装特征而受到阻碍,当面对衣服颜色,风格变化时,导致识别准确率显著下降。本文提出了一种用于CC-ReID的数据增强框架——局部不变特征转换与服饰对抗解析。该框架包括局部不变特征转换(LIFT)模块和服饰对抗解析(CAP)模块。LIFT模块通过随机区域擦除、区域颜色扰动等局部转换方式提取行人在不同服饰下的稳健特征,从而提高模型的鲁棒性。与此同时,CAP模块着眼于不同服饰风格之间的对抗性关联,解析其轮廓差异,挖掘跨服饰的关联特征。通过在两个模块之间交替应用特征关联策略,模型在训练过程中不断优化,提高对不同服饰的适应能力。

图3 局部不变特征转换与服饰对抗解析框架图

实验结果表明,本文方法在换衣行人重识别公共数据集(LTCC、PRCC和CCVID)上与当前最先进的(SOTA)方法对比,取得了具有竞争力的性能。

成果4:“Domain generalized person reidentification based on skewness regularity of higher-order statistics”被人工智能、知识发现等领域顶级期刊《Knowledge-Based Systems》(中科院一区Top,IF 7.6)接收。该论文由熊明福老师指导的2022级硕士生徐洋完成,论文的第一单位为武汉纺织大学。

文章链接:https://www.sciencedirect.com/science/article/abs/pii/S0950705124008402

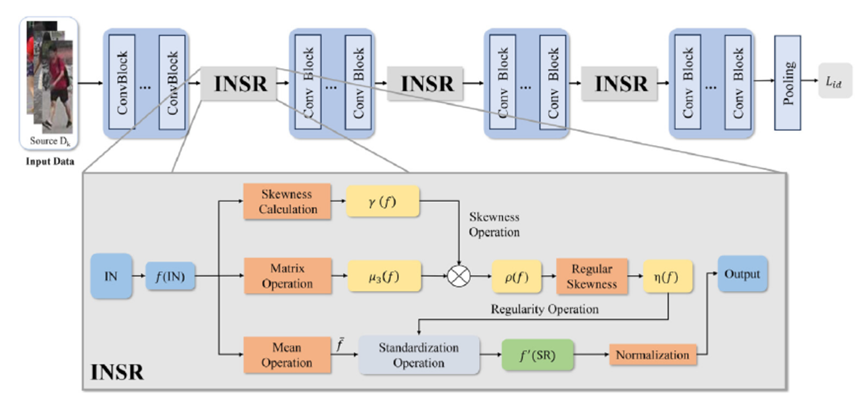

域泛化行人重识别(Domain generalized person reidentification,DG-ReID)旨在训练一个模型,使其能够在源领域进行训练,并直接应用于未见的目标领域。传统的行人再识别方法大多依赖低阶统计量(如均值、方差等)来稳定源领域的数据分布。然而,这种方法的假设条件是数据呈高斯分布,而现实中许多数据分布并不满足这一假设,导致其广泛应用受阻。本文提出了一种基于高阶统计量偏度的域泛化行人重识别框架。该框架结合了实例归一化、偏度操作,通过引入引入高阶统计量和正则化机制,从数据的非对称性中提取丰富的特征信息,提升了模型对不同领域的适应能力,增强模型对复杂数据分布的识别能力,并且有效减轻不同领域之间的分布差异对模型性能的影响,提升了模型域泛化能力。

图4 高阶统计量偏度算法框架图

实验结果表明,本文的方法通过两种评价策略,在公开数据集上,均获得了具有竞争性的结果。

成果5:“DSFNet: Dual-fusion network with secondary clustering and feature integration for unsupervised person re-identification”被人工智能、数据融合、信息安全等领域顶级期刊《Information Fusion》(中科院一区Top,IF 15.5)接收。熊明福老师为第一作者,论文的第一单位为武汉纺织大学。

文章链接:

https://www.sciencedirect.com/science/article/abs/pii/S1566253525007730

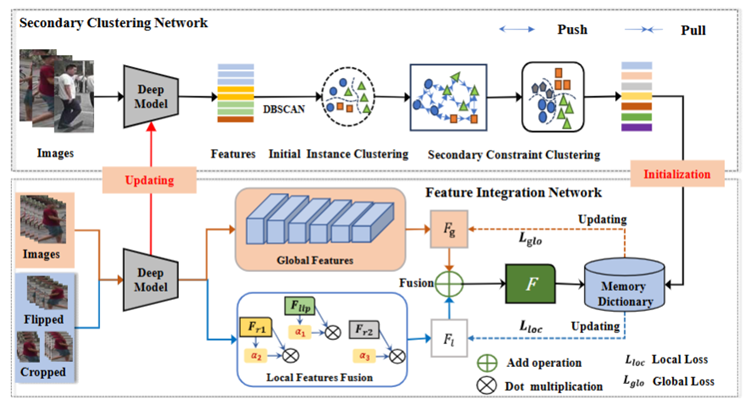

无监督人重新识别(ReID)旨在通过更新样本聚类字典来训练模型,以从不同的相机视图中检索感兴趣的人。由于数据处理成本低,该领域最近引起了广泛关注。现有的方法主要集中在利用单一的固定优化方法(网络)对所有特征进行聚类,忽略了它们的多样性和完整性,从而导致了噪声伪标签。本研究提出了一种DSFNet框架,即用于无监督人ReID任务的二次聚类和特征集成的双融合网络(DSFNet)框架。所提出的框架由三个主要部分组成:(1)硬样本二次聚类网络(SCNet),(2)特征集成网络(FINet),以及(3)双融合动态优化(DDO)方案。分别从原始特征聚类,局部和全局特征提取以及双合动态优化机制三个方面完成模型的训练,有效提升了无监督行人重识别的精度。

图5 二次聚类和双向优化结构

实验结果表明,本文的方法在行人重识别4个公开主流的数据集上,均获得了具有竞争性的结果,为无监督视觉方法的推广提供了技术支撑。

熊明福:工学博士,硕士生导师,IEEE会员、中国图像图形学学会会员、中国计算机学会CCF会员。主要从事多媒体信息处理、人工智能、计算机视觉等方面的研究。近年来来主持湖北省科技计划重点项目,湖北省专利局重大专项,湖北省自然科学基金面上项目等,参与国家重点研发,国家自然科学基金重点等各类国家及省部级项目10余项;2022年获得湖北科技进步二等奖(序2),粤港澳科技成果奖;近5年在ACM MM, TMM, TCSVT, TOMM, TVT, SCIENCE CHINA Information Sciences, Information Fusion, CACAIE, KBS等顶级会议及期刊上发表论文40余篇,申请专利10余项。