2025年6月25日下午2时,计算机与人工智能学院第五十九期研究生学术论坛在崇真楼南楼A4030成功举办。本次论坛由2023级研究生胡广成、饶忠睿、付江琴、吕加锋、王宝辉主讲,计算机与人工智能院研究生会学术部主办,学院阮晓莉老师出席了该论坛。

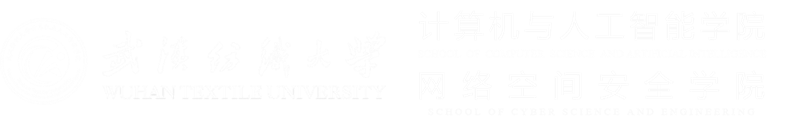

胡广成同学分享的主题为“TrustUQA: A Trustful Framework for Unified Structured Data Question Answering”。针对自然语言问答在结构化数据(如表格、知识图谱和时序知识图谱)上的泛化能力差与信任度低的问题,他提出了TrustUQA框架,通过统一的Condition Graph(CG)对多种数据源进行表示,并利用两级示例检索结合大模型生成查询语句来执行CG查询,以保证答案的准确性与可解释性。为进一步提升性能,TrustUQA还引入了动态示例检索机制,以自适应地选择最相关的演示示例。在涵盖表格、知识图谱和时序KG的5个基准上,TrustUQA不仅超越了已有的两种统一QA方法,而且在其中两个数据集上达到了最新的领先水平,展示了其在混合与跨源问答场景中的良好扩展性与可信度。

饶忠睿同学分享的主题为“ArmBCIsys: Robot Arm BCI System with Time-Frequency Network for Multi-Object Grasping”。他们的研究针对残障人士使用消费级脑电设备在复杂环境下的物体抓取问题,提出ArmBCIsys系统,该系统集成时域卷积与频域Transformer双分支脑电解码网络DBFENet、基于分割的视觉引导,以及实时机械臂控制模块。DBFENet结合时域卷积与DCT频域建模,有效提升脑信号识别精度。实验在自采数据集上取得98.56%的解码准确率,验证了系统的鲁棒性与实用性。

付江琴同学分享的主题为“SeqTrack: Sequence to Sequence Learning for Visual Object Tracking”。视觉目标跟踪传统方法通常需要设计复杂的多任务网络结构,如分类头、回归头以及多个损失函数,导致框架臃肿且训练困难。针对这一问题,SeqTrack创新性地将跟踪任务转化为序列生成问题,采用简洁的编码器-解码器Transformer架构。编码器负责提取视觉特征,解码器则以自回归方式逐词生成边界框坐标,仅需单一交叉熵损失函数即可完成训练。这一方法通过序列化建模将连续坐标离散化为token序列,不仅统一了任务形式,还省去了复杂的头部网络设计,大幅简化了框架。同时,SeqTrack创新性地利用Token似然实现动态模板更新等先验知识融合,进一步提升了跟踪的鲁棒性。该研究为视觉目标跟踪任务提供了一种高效、简洁的新范式。

吕加锋同学分享的主题为“GA-FusionNet:Global adaptive fusion network for RGBT tracking”。针对现有 RGBT 跟踪方法中固定融合结构、动态加权机制缺失及多尺度信息利用不足的问题,提出 GA-FusionNet。该网络借助预训练编码器独立提取 RGB 和 TIR 模态特征,通过全局自适应融合模块基于场景动态生成模态权重,并将各层融合特征级联形成多尺度表示。实验表明,其在多数据集上性能优于 SOTA,尤其在低光、遮挡等复杂场景表现更优。

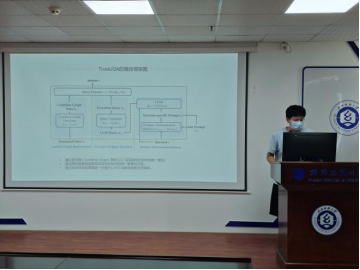

王宝辉同学分享的主题为“Intelligent Question-Answering System Based on the Knowledge Graph of Ancient Costumes”。他提出融合实体识别与意图识别的问答系统架构。前者为处理歧义和上下文依赖问题,捕获领域特定术语,基于RoBERTa深度学习精准提取服饰信息,引入多尺度特征融合模块和规律抽取模块,从而提高模型的性能和泛化能力。后者借千问大模型解析用户意图。经训练测评,实体识别模型F1值达95.43%,问答系统准确度、满意度表现优异,泛化能力良好,为该领域研究提供新方向。